Анонс игровых видеокарт от NVIDIA на базе архитектуры Turing вызвал немало вопросов, и даже спустя некоторое время после выхода «старших» моделей многие из тех вопросов остаются актуальными. Бюджетные видеокарты этой серии ещё не анонсированы, а цены на RTX 2080 Ti, 2080 и 2070 остаются крайне высокими. При этом большинство игр, которые могли бы наглядно продемонстрировать главную особенность нового поколения видеокарт, ещё не вышли (Atomic Heart), или поддержка в них должна появиться лишь в будущем (Shadow of the Tomb Raider).

В этом материале мы попробуем разобраться, почему такой шум в контексте новых видеокарт вызвала именно поддержка трассировки лучей, а не прочие нововведения — память GDDR6, VirtualLink, NVLink и 8K HEVC.

В чём идея трассировки лучей?

Суть технологии звучит достаточно просто: она отслеживает взаимодействие лучей с поверхностями, на которые эти лучи падают. Соответственно, они могут отражаться, преломляться или проходить насквозь.

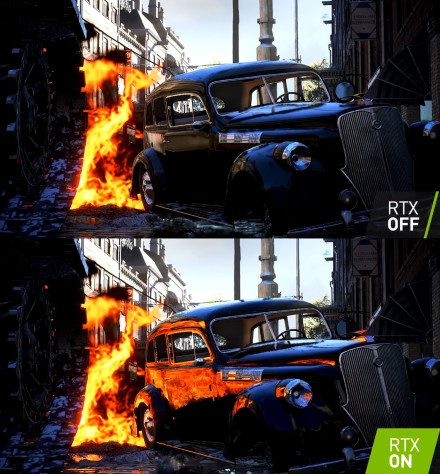

Как видим, главное отличие — появились отражения огня на других объектах. Эти отражения возникли в результате выстрела из танкового орудия. Иначе говоря, добавился новый источник света, и лучи, исходящие от него, были отражены в глянцевом кузове машины, в диске оставшегося колеса и луже. И каким бы странным ни был такой огонь даже на фоне прошлых частей Battlefield, сами эффекты трассировки были показаны очень наглядно и зрелищно.

Но чтобы лучше понять масштаб нововведений, которые могут нас ждать в будущем, проведём небольшой экскурс в историю.

Как родилась технология?

Сама идея трассировки лучей далеко не нова и вполне успешно применялась в области моделирования, а если точнее, в визуализации и рендеринге.

Началось всё с метода «бросания лучей» (ray casting), который был создан для вычисления гамма-лучей, то есть для изучения радиации. Первый вариант для рендеринга был представлен в 1968 году учёным Артуром Аппелем (Arthur Appel). Суть метода заключалась в генерации луча из точки наблюдения (один луч на один пиксель) и поиске самого близкого объекта, который блокирует его дальнейшее распространение. На основе этих данных с помощью алгоритмов компьютерной графики можно было определить затенение данного объекта. Сам термин ray casting появился лишь в 1982 году.

Следующий важный этап начался в 1979-м. Дело в том, что алгоритмы бросания лучей прослеживали путь луча от наблюдателя лишь до столкновения с объектом. Учёный Тёрнер Уиттед (Turner Whitted) продолжил этот процесс. В его алгоритме луч после попадания на поверхность мог создать три новых типа лучей: отражение, преломление и тень. Соответственно, можно понять, что трассировка лучей — это более сложная серия задач, которая не только использует ray casting для определения точки пересечения луча и объекта, но и вычисляет вторичные и третичные лучи, которые могут быть применены для сбора данных. Те, в свою очередь, нужны для расчёта отражённого или преломлённого света.

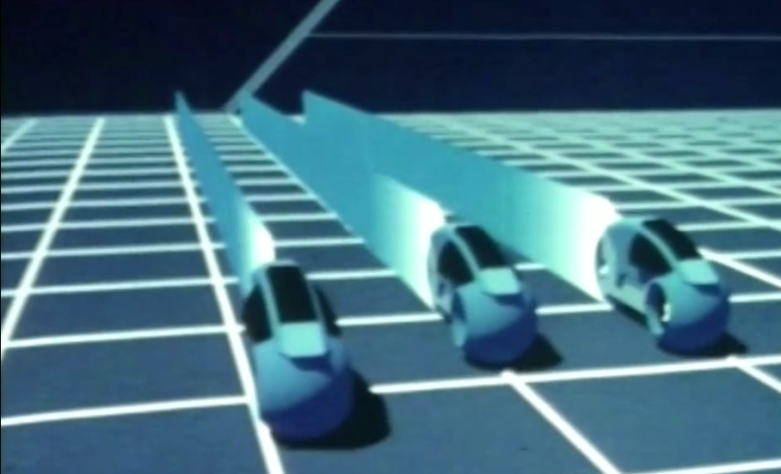

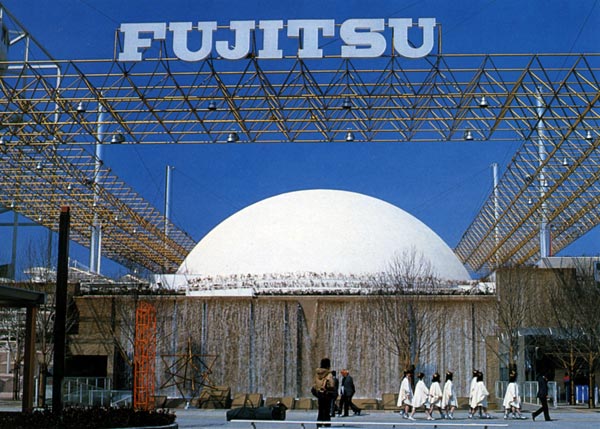

В начале 80-х в Осакском университете группа профессоров и студентов создала LINKS-1 — компьютер, работающий на 514 микропроцессорах. Устройство было предназначено для создания трёхмерной графики с использованием трассировки лучей. В 1985 году в павильоне Fujitsu на международной выставке в японском городе Цукуба был представлен первый видеоролик для планетарных залов, полностью смоделированный на LINKS-1.

В 1984 году была продемонстрирована BRL-CAD — созданная Баллистической исследовательской лабораторией США система моделирования. Спустя три года для неё был представлен трассировщик (raytracer), особенностью которого была хорошая оптимизация. Общая производительность при рендере доходила до нескольких кадров в секунду, пусть и достигнута она была с помощью нескольких машин с разделяемой памятью. Сама BRL-CAD сегодня относится к программам с открытым исходным кодом и иногда обновляется.

Где трассировка оказалась полезной?

Здание отражает солнечный свет так, что на соседней улице плавятся вещи, а люди не стесняются разогревать еду на тротуаре. Одним из пострадавших стал припаркованный Jaguar XJ, у которого от перегрева растеклись зеркала и эмблема.

Но Walkie-Talkie — не единственное сооружение, доставившее проблемы из-за солнечных лучей. К таким зданиям относятся концертный зал Walt Disney в Лос-Анджелесе и отель Vdara в Лас-Вегасе. Подобный эффект получил название «лучи смерти» (death rays). В 2015 году NVIDIA приводила эти здания как примеры ошибки, которой можно было бы избежать с помощью её новой технологии физически корректного рендеринга.

Выходит, что трассировка уже применяется в 3D-моделировании, но за это время и «железо» стало мощнее, и задачи сложнее. О сложностях и поговорим.

Проблемы трассировки лучей

Главной проблемой трассировки лучей является производительность. Для вычислительной техники нет ничего сложного в том, чтобы просчитать поведение одного луча. Но даже если взять сцену, в которой присутствует один источник света и малое количество предметов, в пределах 10, то лучей будет огромное количество. После каждой смены положения камеры необходимо заново просчитывать все эти лучи.

Когда речь идёт о сложном моделировании важных для науки вещей или о создании фильмов (где используется pathtracing, но и каждое движение известно заранее), там есть время на то, чтобы компьютеры долгое время визуализировали каждую секунду.

Роль Unity, Microsoft и NVIDIA в том, что мы видим сегодня

Сейчас мы подошли к моменту, когда стоит начать говорить именно о трассировке в реальном времени. В играх положение нашего персонажа постоянно меняется, сами объекты тоже двигаются. Всё это делает нашу и без того скверную в плане производительности ситуацию ещё хуже.

В 2008 году Intel показала демонстрационные материалы исследовательского проекта Quake Wars: Ray Traced, основанного на контенте Enemy Territory: Quake Wars. Производительность была на уровне 14—29 кадров в секунду при использовании нескольких четырёхъядерных процессоров и 20—35 кадров с шестиядерными процессорами. Видеокарта была также от Intel, на архитектуре Larrabee, конечные продукты которой так и не поступили в продажу.

В 2009 году NVIDIA анонсировала Optix — бесплатный пакет программного обеспечения для работы с трассировкой на видеокартах. Совместимыми программами стали Adobe After Effects, Autodesk Maya, 3ds Max и другие.

Новейшая история трассировки лучей в играх началась с Brigade, игрового движка, который смог продемонстрировать достойные результаты трассировки в реальном времени. Само собой, они были не такими красивыми, как картинка в Unreal Engine 4 со статическим освещением, но в Brigade можно было менять количество и характеристики источников света и результат был виден сразу. А в UE4 для полноценного итога требовался рендер с помощью актуальной версии V-Ray.

Само собой, такие результаты не могли остаться незамеченными, и Brigade стала частью графического движка OctaneRender, который вошёл в известный вам Unity. В свою очередь, Unreal Engine принял в себя наработки GPUOpen — пакета программного обеспечения, предлагающего расширенные визуальные эффекты.

Microsoft сделала дополнение к API DirectX 12 в виде DXR (DirectX Raytracing). Позже AMD (создатель GPUOpen) ввела поддержку рейтрейсинга в свой API Vulkan.

А уже в этом году NVIDIA анонсировала и выпустила игровые видеокарты на архитектуре Turing, подразумевающей наличие RT-ядер для работы именно над трассировкой лучей и тензорных ядер (Tensor cores). Последний тип ядер достался в наследство от предыдущей архитектуры — Volta, на базе которой существует всего две разновидности продуктов (Titan V и Quadro GV100), и стоят они очень дорого. Тензорные ядра предназначены для более быстрого решения задач глубинного обучения.

О производительности

Как мы помним, при любом движении камеры все лучи в сцене приходится просчитывать заново. Если же в один момент просто замереть, просчёт, скажем так, этого кадра не остановится и будет бесконечно уточнять то, что мы и так уже видим после пары минут простоя. Даже на более слабых в сравнении с RTX картах спустя несколько секунд можно понять, как будет выглядеть итоговая картинка, только на ней будет присутствовать большое количество «шумов».

И здесь мы вспоминаем про Optix, в котором с версии 5.0 используется AI-Accelerated Denoiser. Это технология, призванная с помощью натренированных нейронных сетей рисовать картинку, похожую на то, что создавалось с помощью трассировки. В плане затрат мощности такой подход намного проще, но итоговый результат будет хуже, чем полученный с помощью «честной» трассировки.

Что имеем сегодня?

В играх, где нет трассировки лучей, производительность серии Turing дала стандартный прирост производительности для смены поколения в пределах 20% (хоть и не без неожиданностей).

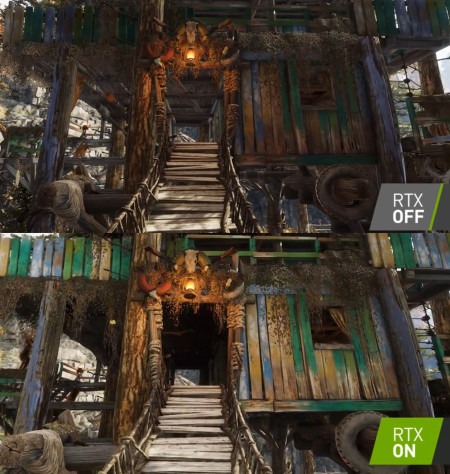

Из игр с трассировкой лучей имеем только Battlefield V. Стоит заметить, что при включении настроек RTX производительность сильно падает. В плане картинки лучше самостоятельно сравнивать то, что получилось, с тем, что показывали на презентации.

В профессиональном софте, как и ожидалось, изменения дали результат в лучшую сторону. Но при выборе помните, что прирост одинаковый не во всех программах: где-то он составляет до 20 % (может и выше), а где-то — десятую долю процента. Например, в OctaneRender сцена Spaceships обработалась на RTX 2080 быстрее на 12 % в сравнении с GTX 1080 Ti.

Больше примеров

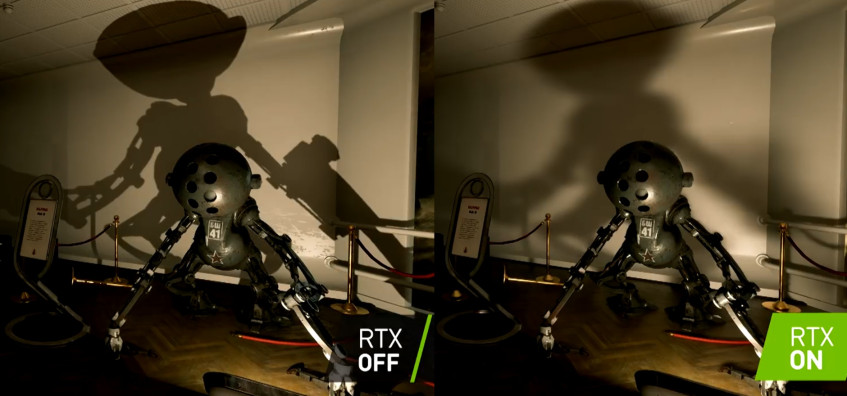

В Atomic Heart кроме более мягкой тени можно заметить, что в варианте без RTX справа от робота в стену будто кто-то бросил пакет кефира. Cо включёнными настройками RTX свет от источников в той области более-менее ровный.

В «Метро: Исход» трассировка лучей смогла повлиять даже на атмосферу. Лично мне новый облик кажется слишком жизнерадостным, но это заметно только при сравнении «до» и «после».

Определённо, трассировка лучей в реальном времени может стать важной ступенью на пути игр к фотореалистичной картинке. Но мы надеемся на скорый приход реалистичных теней, отражений в зеркалах и возможности разглядеть противника за спиной, уставившись на отполированную поверхность.

Текущие результаты слишком ранние, чтобы полноценно говорить о том, стоило ли отложить внедрение трассировки в реальном времени ещё на несколько лет, до появления готовых продуктов со стороны видеокарт, софта и игр. Многое зависит от того, заинтересованы ли в технологии AMD и Intel, — конкуренция дала бы больше уверенности в том, что про текущие наработки не забудут с выходом PlayStation 5 и видеокарт от Intel.

В любом случае Unity в своём докладе упомянула подходящий к концу 2018 год как этап, когда в играх только начала появляться трассировка лучей в реальном времени. По словам компании, широкое распространение технология получит лишь в 2020 году.

Лучшие комментарии

За свою историю (которая насчитывает уже несколько десятилетий) реалтайм-рендеринг изобрёл вагон и маленькую тележку способов сократить количество отрисовываемой геометрии. Такие прелести, как frustrum и occlusion culling, distance sorting и ранняя depth rejection, отключение физики за пределами экрана (offscreen evaluation), и т.п.

Абсолютно всё это идёт лесом в случае с RTX. Количество вычислений на абстрактный фрагмент (~пиксель) само по себе увеличилось из-за этих их гигалучей, да. И увеличилось кратно. Но не это самое страшное. А то, что при таком увеличении мы больше не можем использовать никакие ухищрения, которые позволили бы сократить количество самих этих просчётов (фрагментов).

Просто чтоб был понятен масштаб проблемы:

сам стандарт рендеринга (графический конвейер) предполагает целый ряд этапов, на которых часть отрисовываемой геометрии отбрасывается.

Сперва отработал вертексный шейдер. После этого позиции треугольников оказались в экранном пространстве и видеокарта должна отбросить те из них, которые вылетели за экран. Следом она проверяет, а полученный полигон вообще смотрит на нас лицевой стороной или обратной — и если обратной, то, опять же, выкидываем.

Потом треугольники растеризовались в пиксели (фрагменты) и видеокарта — опять же, должна отбросить те фрагменты, которые либо вылетели за экран, либо уже закрыты теми треугольниками, которые ближе.

Следом отрабатывает пиксельный шейдер. И — опять же — зачастую он на раннем этапе отказывается от вычислений пикселя, если видит, что тот в любом случае не будет записан в буфер (т.н. alpha-clip).

Именно это позволяет нам в современных играх получать такой красивый графен. Без этих базовых ускорений никакой Крузис с Баттлой были бы невозможны, ну вот правда.

Но и это не всё. Концепция RTX противоречит самой архитектуре видеокарты. Дело в том, что эта железка во главу угла ставит один-единственный принцип: «разделяй и властвуй».

Вся работа дробится на хренову тучу мелких и не зависящих друг от друга задач. Этот концепт пронизывает буквально всю архитектуру GPU. На рассчёт каждой вершины поступают только её данные. При обработке каждого пикселя на каждое ядро отсылается только тот кусочек текстуры, который нужен конкретно этому ядру. Именно это позволяет обрабатывать пиксели так быстро, ведь все необходимые данные целиком влазят в крохотный, но очень шустрый кэш ядер.

Очевидно, что в случае с RTX — буквально каждому пикселю требуется работать чуть ли не со всей сценой разом.

Решения есть, да. Но и тут не всё так радужно. По факту, лучшее, что может сделать нвидия для ускорения процесса — это адаптировать те оптимизации рейтрейсинга, которые использовались в киношном рендере лет 10 назад. Вот тут-то и кроется загвоздка:

1. далеко не все эти оптимизации в принципе можно перенести на GPU, с её уровнем параллелизации.

2. большинство из этих оптимизаций очень плохо дружит с концепцией «много мелких ядер, решающих свою маленькую задачу». Попросту невозможно аналитически предсказать, какие конкретно данные потребуется при расчёте конкретного пикселя.

Что мы имеем в сухом остатке.

RTX — это технология не для геймеров, а для киноделов.

Да, с точки зрения классического рендера — это просто невероятный рывок. Но конкретно в реалтайм-графике из-за всех этих проблем (большинство из которых неустранимы фундаментально) получается, что если просто делать игры старым образом, пользуясь старыми технологиями — картинка выйдет лучше и будет жрать меньше ресурсов.

Да, эти технологии надо знать игроделу. Да, надо пошаманить, чтоб их правильно задействовать. Но по итогу правильно приготовленная игра с «классическим» current-gen рендером выдаст лучший результат, чем RTX. Если смотреть на игру в целом, а не на отдельно тени или отдельно отражения.

Мне пока оптимально подходит режим «ответственного комментатора», который в состоянии дополнить публикацию, если есть чем — но не пыжится выжимать из себя текст, если нечем.

2. У меня с СГ просто не получилось найти такого формата, который бы устраивал обе стороны.

3. Я продолжаю вести технические стримы вперемешку с обилием гомогейства у себя на твитч-канале. Но поскольку это мой канал, а не СГ-шный, тут это никак не анонсирую/продвигаю.

4. Для меня вся эта около-игрожурская движуха окончательно перешла на второй план, в качестве крайне опционального хобби. Есть желание — стримлю. Нет — так нет. Никаких расписаний, согласований, утверждения обозреваемых тем и т.п.

5. На стримах не появляюсь — потому что не зовут. Поводов нет. Я ж не умею в развесёлый балаган, у меня всё на серьёзных щах. В общую атмосферу не особо вписываюсь.

Что-то пока что суть этих технологий выглядит как смесь костылей и велосипедов. Хотя не могу не сказать, что результат с «истинными» отражениями и тенями поражает воображение.

Да, Нвидия — самый революционный революционер из всех революционеров, революционно релизящий абсолютно революционные технологии.

Я это к тому, что надо дождаться выхода новых дров и обновлений, может они исправят ситуацию с FPS в BF V, ну и конечно больше игр с данной технологией, что бы оценить ее полностью и ответа AMD в виде карт с поддержкой лучей для потребительского рынка.

Есть нечто новое, что целесообразно. А есть — просто новое ради нового.

Лет 5 назад много где громко шумела технология Unlimited Detail. По сути, алгоритм рендеринга поинт-клаудов. Концептуально — ничего нового, хоть и старалась строить из себя революцию. Амбиций было — немеряно.

Ну и где они сейчас? В играх — нигде.

Потому что внедрению этой технологии мешал ряд объективных факторов. Она, заявляя о своей революционности, предлагала отбросить все те наработки, которые уже были в шейдинге на тот момент. В том числе — самые базовые, вроде наличия нормали или меша как такового.

В чём её отличие от RTX? В том, что там нас хотя бы не заставляли ради знакомства с сабжем покупать отдельную специальную дорогостоящую железку, а практический результат — хотя бы на каких-то готовых примерах могли показать.

RTX ломает графический пайплайн на таком глубоком уровне, что целые фрагменты архетектуры перестают работать. Предварительная подготовка данных в режиме RTX практически невозможна. А это ломает такой базовый концепт GPU, как массовая параллелизация.

Следовательно, краеугольный камень RTX — это память. Быстрая память. Очень быстрая память.

Если нвидия не придумает, как бы так сделать, чтоб доступ к обычной видеопамяти для каждого произвольного ядра был почти таким же по скорости, как доступ этого же ядра к кэшу — то RTX не просто «может подтормаживать». Нет, она тогда просто обречена люто тормозить.

А возможности создать такую память противоречит один маленький нюанс: физика.

Революционно.

Апскейл рендера в 1080p до 4К, денойз, устранение артефактов, антиалайзинг — вот это всё.

Но — да — явно не за такой конский ценник.

То есть, сам RTX никому кроме киношников не впёрся. Но вот те технологии, которые его обеспечивают — очень даже интересны и сами по себе, в отрыве от рэйтрейса.

Для этого и придумывают всякие RT и Тензорные ядра.

Ну если такими тезисами мыслить, то зачем придумывать что-то новое, ведь и старое прекрасно работает? И сидело бы человечество в каменном веке.

И да, привет, игры с raytracing выходят с 2009 года (важно лишь осознавать, что эта технология с каждым годом улучшается).

Ах да, и компьют-шейдеры (а также и геометрические, и hull-, и domain-) никак не противоречат классическому пайплайну, а лишь расширяют его. В отличие от нового детища нвидии.

В общем, предлагаю сойтись на том, что RTX в том виде, который есть сейчас — нам не нужен. Он нужен киношникам. Ну так и релизили бы эту фичу как эксклюзив для «квадр» и «титанов». Там такие цены в порядке вещей.

Я понимаю, что ща Нвидии надо придумать, как распродать 10-ое поколение видюх. И тактика заградительной цены на RTX — это отличное win-win решение. Но, как ты верно подметил, это свинство. И фаны нвидии первыми должны возмущаться но то, как о них вытирают ноги.

Никакая технология не может рассматриваться в отрыве от цены, и именно цена — это то, что превращает RTX из безвредной побрякушки в прожорливую технологию с кучей проблем. Которые — я убеждён — потенциальный потребитель должен отчётливо осознавать, прежде чем покупать это.

Моя позиция: RTX не жизнеспособен до тех пор, пока он не сможет выдавать:

* одновременно все фичи сразу (тени + отражения + рассеянный свет)

* с высокими показателями размытия

* без существенной просадки fps

* на контенте примерно такой же детализации

* за адекватную цену

И у меня есть обоснованные сомнения, что это хотя бы гипотетически может произойти не то что в этом поколении видюх, но даже в ближайших трёх. А значит, на ближайшие три поколения RTX — это не более, чем попытка за наш счёт продвинуть то, что конкретно нам — не нужно.

Нужно тем, кто юзает видюхи для нейронок. Нужно тем, кто рендерит кино.

Но не нам. Нам предлагают — кривой-косой суррогат за конский ценник.

С этими тезисами не поспоришь, действительно так)