Анонс Nintendo Switch 2 мягко скажем произвёл нешуточный ажиотаж среди консольных геймеров и любителей портативного гейменга, но никто не замечает самое главное и важное в новой консоли от большой Н, это её железо.

Да официально нету полной информации о железе консоли, но инсайдеры еще в 23 году слили почти полные спецификации портативной консоли её экран а так же что Joy conы будут магнитными и всё это подтвердилось практически, так что не верить данным после такого это странно.

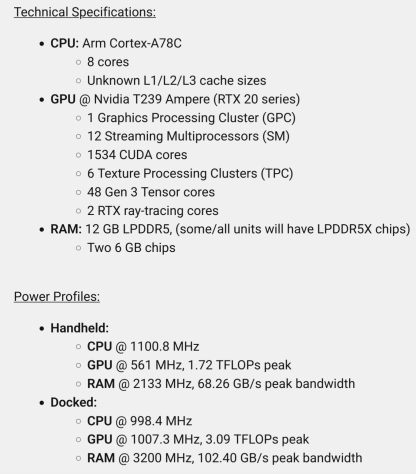

Теперь к железу

Архитектура Ampere то есть 3000 линейка от инвидии но с самым мизерным количеством CUDA ядер в линейке, однако тензорных ядрер отвечающие за апскейлер DLSS 48 штук так еще и 3 поколения которые стоят только в 4000 линейке, чисто теоретически и крайне осторожно можно надеяться на фрейм генератор на новом свитче, а новая версия тензорных ядер позволит запускать 3.7 версию DLSS на консоли то есть самое качественное сглаживание и апскейлер в игровой индустрии (до выхода на полки магазинов 5000 серии).

Что забыли 2 RTX ядра в нинтендо свитч 2? я считаю что это Инвидия протолкнула RT ядра ведь RTX портативной консоли НЕ НУЖОН А ТЕ КТО СЧИТАЕТ ЧТО НУЖОН СУМАШЕДШИЙ.

Ядра Cortex A78 в процессоре не смотря на то что являются топовыми на момент начала 2022 года к 2025 году устарели, с другой стороны за это время эти ядра обкатали и улучшили все кто мог так что стоит ожидать холодного процессора с приемлемой мощностью.

Ну и конечно 12 гигов общей памяти, кто-то скажет мало, а я скажу что в Xbox SS стоит только 10 из-за чего у него огромные проблемы с оптимизацией того же вуконга, можно спокойно рассчитывать что те игры которые запускал Xbox SS будет запускать Свитч 2.

Обобщённо можно сделать вывод что в свитче 2 будет железо даже немного лучше Xbox SS благодаря лучшему апскейлеру хорошим тензорным ядрам (Чего очень сильно не хватает этому консольному поколению), а так же качественной архитектуре Ampere которая так хорошо себя зарекомендовала что Инвидия не может убить 3000 серию уже на протяжении 2 поколения своих видеокарт.

Подводные камни такого железа.

1. Сразу возникнут вопросы с охлаждением, если с процессором всё понятно это ARM на не самых новых но обкатанных ядрах которым хватит и бруска алюминия для охлаждения, то что придумала большая Н для видеокарты, ведь даже не смотря на общее урезание чипа как по частотам так и по CUDA ядрам (С сравнению с 2050/3050) его ТДП меньше 40ватт не будет(40 ватт минимально возможное ТДП у чипа 2050 и 3050 в ноутбуках), а для этого нужно как минимум 2 медные термотрубки и хороший кулер, тут 1 из 2 либо Свитч 2 будет как Стим Дек по весу в угоду охлаждению либо очень громким и горячим.

2. Портативный режим, по скрину выше те кто по глазастее могли обратить внимание что ГПУ и ОЗУ теряет в производительности чуть меньше 50% в портативном режиме, да это приведёт к более адекватному расходу аккумулятора, но потеря в скорости шины и общей производительности ГПУ моментально скажется на ФПС и качестве графике и тут на помощь приходит DLSS который сильно сгладит проблему, но как DLSS при экране в 1080p будет смотреться нужно тестировать на практике.

Почему железо будет именно таким

1. Заинтересованность Инвидия: НИ для кого не секрет что начиная с начала 10 годов Инвидия хочет втиснуться в мобильный гейминг более того корпорация делала и свою консоль на ARM процессоре Nvidia Shield и судя по недавним слухам Инвидия собирается вкатываться снова на этот рынок но уже с своими новыми ARM процессорами и ГПУ, и нинтендо свитч 2 ИДЕАЛЬНО подходит для тестового полигона не только технологий но и железа в частности.

2. Нинтендо Свитч 1: Казалось бы причем тут 1 свитч, а при том что его слабая начинка была не более чем НЕОБХОДИМОСТЬЮ, я напомню что до Свитча 1 была Wii u которая наглухо провалилась в продажах и по сути чуть не убила большую Н и только совпадение обстоятельств таких как провал nvidia shield с её NVIDIA Tegra которая оказалась никому не нужна и была дешевой помогла большой Н оставаться на плаву, добавьте к этому общее слабое консольное поколение PS4/Xbox one (в частности очень слабым был Xbox ONE), а значит рынок не требовать больших мощностей железа плюсуйте к этому СВОБОДНЫЙ рынок портативных консолей и суицид ПС вита и получите дешевый, но рисковый вариант занять свободный и слабый рынок.

Сейчас же всё поменялось, мало того что это консольное поколение оказалось довольно мощное (кроме Xbox ss он вообще никому не нужен), так еще и на портативном поприще появился Стим Дек и куча других конкурентов по меньше, по этому большой Н ну никак нельзя выпускать консоль с железом уровня ниже того что ранее показывал, да большая Н может позволить себе выпустить Свитч 2 слабее тех утечек, но кому тогда нужна будет такая консоль если большинство разработчиков вообще забили на оптимизацию и плюются на Xbox SS, то есть повториться провал WIi u я думаю в Нинтендо сидят не глупые люди.

3. Цена: Не смотря на то что характеристики Свитч 2 могут показаться дорогими нельзя забывать что это железо уже сейчас устарело ПУСкай не так сильно с сравнению с свитчом 1, а это значит что железо внутри Свитча 2 по себе стоимости довольно дешевое буквально впритык, поставишь слабее но дешевле не хватит производительности, поставишь дороже но мощнее будет высокая цена, а главная фишка Свитча была в том что он дешевым был.

(Не берем в расчёт старт продаж любая техника на старте ультра-дорогая)

Итог:

С 95% вероятностью слитое железо будет в Нинтендо Свитч 2, иначе по другому быть не может большая Н заинтересована в этом и сама Инвидия которая давно поглядывает на портативный и мобильный сектор.

Подобное железо позволит не только прожить относительно без компромиссов свитчу 2 и даже обгонять Xbox SS в некоторых играх благодаря архитектуре и большему объёму памяти с DLSS.

Лучшие комментарии

Спекуляции хорошо, конечно, но я бы всё это более предметно обсуждал, когда хотя бы превью-образцы по специализированным блогерам разъедутся (если Нинка вообще этим будет заниматься, а не просто выкатит тираж в магазины). Пока это всё просто гадание на кофейной гуще со сливами, догадки и предположения.

«Да, я буду прав. Вопросы?» Вот так ты будешь прав. А сейчас ты просто всех раздражаешь.

Я вот читаю и думаю: «а какой в этом смысл?» Какой смысл в обсасывании предположений на основе сливов, еще не вышедшей консоли? Что бы потом заорать: «видели, видели?! Я был прав!!!»? Ну ок.

San231«при том что она никогда не гналась за мощностями за всю свою историю.»

Так же консоли Нинки:

Super Snes> мощнее конкурента Sega mega Drive и самая мощная 16-битка

N64> Мощнее Playstation 1 и Sega Saturn и самая мощная 32-Битка

Gamecube> Мощнее Playstation 2 и не сильно уступает Xbox Original

Ок.

Итог:

Шиза

Поддерживаю. Плюс, даже в слитых частотах ЦП в доке\хендхелде явно косяк, который можно объяснить разве что оптимизацией под батарею в режиме хендхелда по типу «выше частоты, меньше задействованных ядер», иначе это просто против всей логики идет. Но в этом случае это сильно затруднит разработку и оптимизацию игр, а на такой поступок лучше производителю не решаться.

Первое правило в игровом сегменте — не упоминать тему о свич🚬🗿

Тебе ж не 10 лет, чтобы тебя учить, епрст… походи по хорошо написанным блогам и посмотри, как там люди общаются в комментах. Как ты к людям относишься, так они относятся к тебе. И свое отношение ты выказываешь как блогом, так и комментариями.

Учись, если хочешь, чтобы твои работы ценили. А если не хочешь — продолжай в том же духе, ты отлично справляешься.

Ты орудуешь спекуляциями из новостей от третьих лиц по отношению к разработчикам консоли, а не фактами. Ты вроде попытался выжать ± максимум из имеющихся слухов, но сама подача и заголовок слишком уж кричащие для гадания на кофейной гуще. Они еще не являются фактами. Все может поменяться. Поэтому народ тебе это и выказывает, припоминая тематику и название. Прав ты, утверждая, что все так будет или не прав — еще неизвестно, ты в суперпозиции как кот Шредингера.

Плюс, я тебе ткнул пальцем, что в сливе частоты для CPU указаны как 1100 для хендхелда и 900 для дока, что выглядит или как опечатка (о чем говорили упомянутые тобой DF, если ты их не слушал) или очень странное решение со стороны инженеров, А ты слился, не лучше тех, в кого тычешь пальцем выше. Поясню: в доке частота должна быть такой же или заметно выше, чтобы компенсировать повышение разрешения, что означает повышение количества drawcall (обращений на отрисовку) к видеоядру.

Еще раз: учись общаться с людьми и писать статьи, если хочешь нормального к себе отношения. Банально, обрати внимание, как я тебе сейчас отвечаю. Без высокомерия и наглости.

Я тебе пишу не просто так, а чтобы дать тебе дельный совет на основе своего немалого опыта написания статей, в.т.ч. коммерческих. Не нужен от меня совет? Окей, на то твоя воля.

Но если так, то да, я зря потратил свои несколько минут жизни на тебя.

Скажешь это тогда, когда это подтвердится.

DLSS в первую очередь снижает нагрузку на GPU, так как реконструирует изображение из более низкого разрешения. Низкое разрешение = нужно гораздо меньше нагружать графический процессор операциями текстурирования, заполнения сцены, расчетами альфа-каналов, глубины буфера и исполнением кода шейдеров. ЦП здесь участвует в меньшей степени, так как его задача — подготовить данные для отрисовки и отправить их по шине с набором команд. И в доке снижать частоты ЦП в данном контексте бесполезно: он меньше задействован, но нужен в большей степени, чем в хендхелде, так как самих операций становится больше.

В доке наоборот надо давать больше мощности, т.к. финальное разрешение выше, чем в портативе. Снижение мощности не бьется никакой логикой, поскольку все еще есть тонна других операций (подготовка ресурсов, игровая логика, ИИ, обсчет коллизий, физики, сопутствующие операции стриминга данных, обсчет медиа, и.т.д.). Тем более, что в доке можно поставить кулер и расположить выходные отверстия охлаждения оптимально для циркуляции воздуха, чтобы рассеять скапливающееся тепло.

Самое адекватное предположение, сделанное DF — это повышение частот с отключением пары ядер в портативе, чтобы снизить энергопотребление и частично скомпенсировать быстродействие. А в доке — вернуть все ядра. Но даже они, с их опытом, сказали, что это звучит в любом случае очень странно. По-разному распараллеливать задачи при сценариях с 5-6 и 8 ядрами — это программистский ад. Ты когда-нибудь пробовал делать параллельные вычисления на ЦП? Я пробовал — это тот еще геморрой с отслеживанием выполнения операций и балансированием нагрузки. Я как разраб софтовый тебе скажу: снижать частоты центрального процессора в доке — это добавлять жирного такого геморроя прогерам при оптимизации. Очень неудачное инженерное решение. Очень надеюсь, что это все-таки опечатка.

Его есть смысл использовать всегда. Зависит от того, сколько жрут тензорные ядра. И заметь, что ты, как и я, сейчас пытаемся угадывать. Это все еще неподтвержденные факты.

RISC-архитектрура действительно жрет поменьше, чем CISC у х86 — за счет более простых для исполнения инструкций. CISC же выполняет больше действий за такт.

У Свитча, например, частоты одинаковые для дока и порататива — 1 Ггц по дефолту. Я не вижу смысла резать проц в доке, тем более, что его питает док всеми 45+ ваттами (или сколько их будет). GPU — самый прожорливый потребитель, поэтому логично, что его режут вполовину в хендхелде. Плюс, да, это бьется с видеорежимом для портативного режима.

Это возможно тогда, когда у тебя у SoC крайне ограниченный TDP-бюджет и вся вычислительная мощь (центральные расчеты+графические расчеты) производится под одной крышкой, как у PS5, например. Там инженеры вкрутили систему балансирования энергопотребления между, собственно, потребителями. И если у PS5 действительно горячее железо, то в случае Свитча надо смотреть — там, скорее всего, базовый бюджет потребления и тепловыделения — 5-8 ватт, иначе у тебя батарея высадится быстро.

Буду рад, если они тебе помогут и действительно окажутся полезными.

Ты, кажется, плохо понимаешь пайплайн рендеринга =)

Смотри: апскейлер разгружает GPU в большей степени, так как нагрузка в отрисовке сцены становится существенно ниже. Я тебе выше описал какие задачи возлагаются на GPU. У него больше всего задач по отрисовке пакета команд (drawcall) от CPU. Задача CPU — быстро эти запросы поставлять. Но это далеко не единственная его задача, у него их там еще до жопы (выше расписывал), и многие из них приоритетны.

Запусти Cyberpunk на средней видюхе и сравни нагрузку по ЦП и GPU с помощью GPU-Z с DLSS и без, раз мне не веришь.

Учи матчасть, друже. Ты утверждаешь странные вещи.

Если у тебя GPU просаживается по задачам, его никакой CPU не спасет. Еще раз почитай матчасть и проведи исслодвание\посмотри чужие тесты.

Ну, тут будем смотреть, что они там придумали. Пока не особо убедительно в плане соблюдения производительности и снижения нагрузки на разработчиков (это далеко не последний фактор при проектировании игровой системы в современном мире).

У них ± общая технология производства. По части троттлинга — это механизм защиты логики на кремниевой подложки от перегрева. Он у них настроен агрессивнее еще и из соображений «не перегреть батарею», поскольку обычно ставится в мобильные устройства, где она есть.

Свитч из соображений экономии батареи задаунклочен даже не на 40%, а на все 150%. С хорошим охладом он держит 2500 мГц на чипе. А многие игры во время загрузки ассетов его прямо на свитче прям в хендхелде разгоняют до 2080 мГц, даунклоча GPU, чтобы сохранить теплопакет и расход энергии.

Я бы хотел, чтобы консоль была спроектирована с запасом теплопакета\мощности на чип в доке. Чтобы, грубо, 10-15 ватт (больше не получится) в хендхелде и 40-60 ватт в доке с нормальным питанием.

А это ты вообще откуда взял? Я тебе про Фому, ты мне про Ерему. Мы обсуждали то, на что влияет DLSS. Задача DLSS — экономить ресурсы графического процессора, а не центрального. Я тебе дал прямой маршрут к тесту, как это проверить. Ты ушел вообще в другие дали, сначала зачем-то начал говорить про задержку, которая формируется из кучи других факторов ВКЛЮЧАЯ GPU И ВРЕМЯ ОТРИСОВКИ ИМ КАДРОВ на основе команд от ЦП, а не только из обсчетов на ЦП. А теперь тебя унесло в утверждение «высокая нагрузка на ЦП != высокий фпс». Как с тобой вообще разговаривать-то? Ты думай логикой, а не блуждай в сказках о железе, епрст.

Мне тебе еще рассказать, что влияет на формирование количества кадров в секунду в той же манере что и выше? Может ты почитаешь, как работают игровые движки сначала? Попробуй сам потыкать в них и в то, как они работают, как это делал я в свое время. Посмотри в профилировщики быстродействия игр, на худой конец.

Просто изучи матчасть, мне аж обидно, что у есть люди с такой лютой кашей в голове.

Еще раз: Запусти Cyberpunk или другую игру с поддержкой DLSS на видюхе с поддержкой этого же DLSS и сравни нагрузку по ЦП и GPU с помощью GPU-Z с DLSS и без, и тогда у тебя вдруг случится озарение и ты поймешь, какую здесь писал чушь.

Фреймтайм, в который ты тычешь, формируется, БОЛЬШИНСТВОМ, из того, сколько времени тратит видюха на отрисовку кадра. То, что он, фреймтайм, неровный, означает, что количество кадров в секунду не попадает в синхронизационный цикл монитора (разуваем глазки и смотрим левый сегмент, там почти 60-61 фпс, попадает в 60гц-интервал монитора с тройной буферизацией кадров), поэтому видюхе не приходится ждать времени вывода кадра. Там где 80 — разумеется, разброд и шатание. Почитай про VRR для этого. Вдобавок, так как в дело вовлечен DLSS, который тоже добавляет время на обсчет кадра и столь тобой любимую ЗАДЕРЖКУ, а время кадра сильно снижено по отношению к сегменту без DLSS, то, разумеется можно получить вот такую гребенку — DLSS тоже тратит ресурсы видюхи и отнимает время на вывод следующего кадра. Один кадр получается сложнее предыдущего для нейросетевой модели.

Если ты хочешь поговорить про отклик, надо смотреть не на ровность графика, а на то, насколько низкое время вывода кадра в среднем.

Не такого понятия «видяхе плохо». Она под бОльшей нагрузкой, так как ЦП не нагружен и может давать больше команд на отрисовку.

Учитывая, что сталкеры и прочее барахло от GSC до второй части на Unreal5 не работает c DLSS и вообще написано обсчетами в однопоток, твои отсылки к нему не имеют никакой релевантности к поднятой теме, поскольку там движок всегда ждет графический процессор, пока тот отрисуется, потому что он так криво написан.

Ты даже знак «не равно не знаешь», еще выеживаться будешь ) Еще и жопой читаешь при этом сообщения и даже не думаешь головой. Поясню для тебя: сочетание != — это знак «НЕ РАВНО» в программировании и не только. Учи матчасть и заканчивай себя закапывать уже.

Я тебе конкретно посоветовал посмотреть нагрузку в процентах на GPU с DLSS и без DLSS, чтобы понять то, что я тебе пытаюсь донести. Ты вообще радикально в сторону ушел.

А теперь вынужденный ликбез. Задержка формируется из того, сколько времени уходит на формирование кадра как на ЦП, так и на ГПУ + сколько уходит времени на тонну логики по обработке остальных подсистем игры. И да, она может уменьшиться, так как нагрузка на GPU снижена и следующий кадр уже выводится быстрее, следовательно, ЦП может обсчитывать логику игры чаще. Попробуй поиграть с 10 fps с перегруженной в пол видеокартой и ненагруженным ЦП. Какая там получится задержка управления? =) То-то же.

Игры работают в циклах. Фундамент всей обработки игрового цикла строится на ЦП, который считает логику игры (здесь обрабатывается ввод с клавы\мыши\геймпада), обрабатывает подсистемы игры, а затем формирует команды для ГПУ на отрисовку и ЖДЕТ их исполнения, параллельно доделывая другие задачи, какие еще остались, если код написан грамотно. Нельзя рисовать кадр отдельно от игровой логики: текущий кадр должен отражать текущее состояние игры. Поэтому повышенная нагрузка на видюху резко увеличит отклик от игровой логики. Разница между двумя состояниями игры считается по дельтам, если кадр рисуется видеокартой уж слишком долго. А так называемая «задержка» вычисляется из того, как быстро твой персонаж\камера реагируют на действия: чем ниже фреймрейт, выдаваемый графическим ускорителем, тем выше задержка. Кроме того, на нее может влиять тонна других факторов: то, как часто обсчитываются команды с контроллера, какая задержка вывода у монитора и ждет ли графический ускоритель такта монитора для отрисовки следующего кадра. Так это работает, и никак иначе.

Еще раз посоветую: изучи матчасть по части того, как формируется изображение в играх. Чую, что я зря трачу время. Понадеюсь, что мои тычки помогут тебе обрести больше знаний, а не плавать в догадках и выдавать пространные рассуждения, крайне далекие от реальности.

Сказочник, заканчивай чушь нести и заодно еще додумывать за остальных, тебе это чести не сделает. Твой список грехов уже вырос так, что мне даже обидно, что я считал тебя тем, кому можно внятно объяснить механику работы железа и софта.

Ты мне еще про время вывода кадра рассказывать будешь, про которое я тебе выше несколько раз рассказал, но в несколько других терминах и контексте.

Окей, ты меня выше читал точно не глазами и не мозгом, и пытаешься убедить в обратном.

Ладно, мне надоело разбираться в хаосе твоих сообщений. Я тебе изначально говорил именно про реконструкцию кадра как часть DLSS 2-4, которая позволяет нагрузить тензорные ядра и разгрузить тем самым растеризационные мощности, если ты еще не понял. А это легко понять по объяснению о сниженном внутреннем / изначальном разрешении изображения, что как раз снижает нагрузку на GPU.

Просто мне уже лень выправлять разговор в адекватное русло, звиняй.

Когда ты упорно игнорируешь и извращаешь то, что тебе говорят и пытаешься все вывернуть в свою сторону, игнорируя логику обсуждаемой матчасти, получается скучная хрень, а не диалог. Возможно, ты начал понимать, что тебе очень хочется прослыть умным и во всем правым, но не получается, поэтому и начал перевирать сказанное, уводить диалог в сторону и игнорировать объяснения.

Высокомерие и желание быть правым несмотря ни на что как раз все портят и возвращают нас к тому, с чего я начал писать тебе. А ещё это очень инфантильная линия поведения. Если понимаешь, что что-то не до конца понимаешь — лучше переспроси и уточни. Или лучше изучи обсуждаемый предмет. И без глупых переходов на личности.

Вот тебе ещё один урок перед сном.

Смотрел презентацию, ничего не подтвердилось, потому что про частоты и железо никто подробно не говорил.

Я без понятия, где ты это нарыл. В презентации этого, что я выделил красным, вообще не было. Ждем тестов или внятных сливов инфы от разработчиков.

Ну ты и агрессор. С такой манерой общаться тут на СГ долго не живут)

Мне какой-то неадекват из сети глубоко до лампочки.

Скоро тебе прилетит пред или бан, кстати. Модераторы читают комментарии. Думай башкой. И научись выражать мысли по-человечески.