Stable Diffusion, бессонница

Пару недель назад, из интереса и, возможно, скрытого желания сгенерировать балерину из Atomic Heart, я установил нейросеть и принялся экспериментировать, сначала с текстовыми запросами, потом с редактированием фото, масками, скетчами и пр.

Слишком далеко я не зашел, но, возможно, начальные инструменты будут интересны тем, кто наткнется на этот, прости господи, "материал".

По поводу установки: как пишут на сайте, на котором я нашел инструкцию, требуется "достаточно мощный компьютер", не меньше 4Гб видеопамяти и 10Гб для установки. У меня Nvidia 3050, 8Гб - картинки больше чем 1000х1000 пикселей может отказаться генерировать, приходится играть с фильтрами и менять размеры (мне интересно генерировать на основе фото, поэтому либо подрезать фото, либо устанавливать фильтры так, чтобы урезалось и форматировалось изображение на выходе). Сами картинки, в зависимости от параметров, генерируются от 1 до 10 минут (мои стандартные эксперименты, я не старался устраивать стресс-тесты).

Инструкция тут https://remontka.pro/stable-diffusion-install-use/#install

Отдельно хочу уточнить что инструкция нифига не полная, в моем случае не установлен компонент для использования nvidia cuda и не особо хочет ставиться, это очень вялая битва, но может когда-нибудь я ее выиграю, пока руковожусь принципом "вроде работает".

Если ссылки нельзя (я тут первый раз пишу), ставил я версию AUTOMATIC1111 с веб-интерфейсом, потому что а почему бы и нет, мне так удобно, не судите меня. Поясню, есть версии которые работают по API напрямую через командную строку. В моей установке возможны оба варианта. Можно даже создать публичную ссылку, чтобы генерировать, например, изображения сидя в телефоне, пользуясь мощностями своего ПК.

За десяток дней пользования я остановился на модели Protogen x3.4, под 6Гб ( так называемые чекпоинты, модели обучения, на которых отработаны удобные сценарии). Кроме моделей есть дополнительные обработчики: Hypernetwork, LoRA, Textural Inversion. Они весят меньше, подключаются к выбранной модели как дополнительные фильтры в виде описания. В случае веб-интерфейса - выбрал - ткнул - появилось в описании. В случае API - не знаю, перестаньте на меня давить.

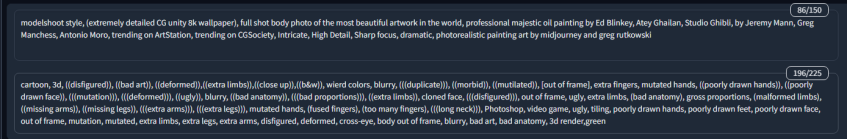

txt2img - вкладка, где сначала вписываешь

Promt - то что ты хочешь видеть на получившейся картинке, от простых словосочетаний до найденных в сети абзацев, по которым можно предположить каким будет изображение.

Negative prompt - то, чего на изображении быть не должно

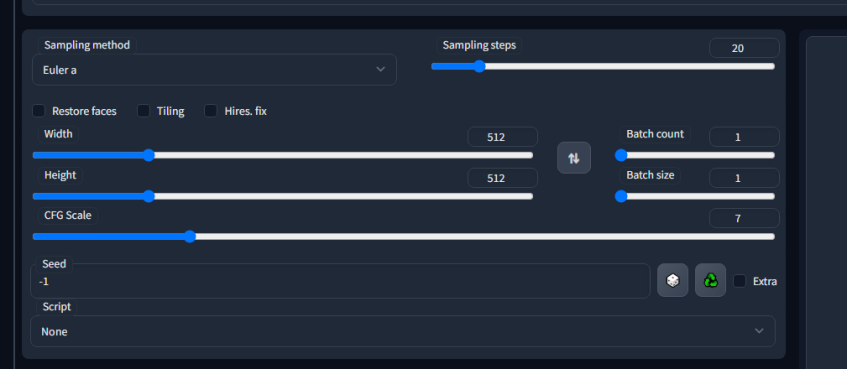

Sampling method - список способов выборки, есть список вариантов, можно переключаться и смотреть на результат генерации, а можно найти интересующую картинку, увидеть какое описание и какой метод выборки был использован и выбрать его. Я делал и так и так, в любом случае интересно, субъективно больше нравится DPM++ SDE Karras

Ширина, Высота, это понятно.

CFG Scale (на самом деле пояснения есть при наведении на свойства) - насколько выходное изображение будет соответствовать описанию, как сильно нейросети разрешено креативить.

Denoising strength - тоже фактически шкала креатива, уже не зависит от описания, чем выше, тем более абстрактно ваше изображение.

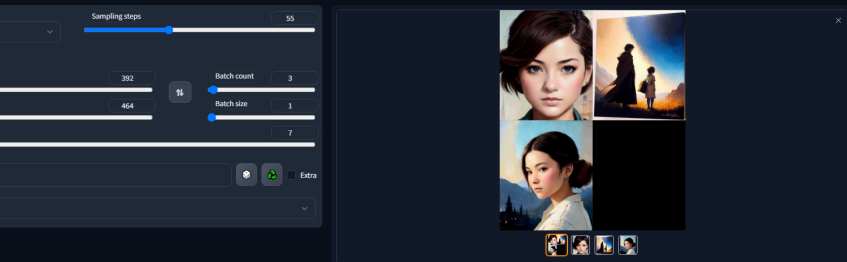

Batch count - сколько сгенерировать изображений. Увеличит время.

Batch size - сколько изображений сгенерировать за 1 прогон. Увеличит количество потребляемой памяти

Sampling Steps (UPD) - чем больше количество шагов, тем больше удаляется артефактов, в большинстве случаев, как пишется в руководствах, после 30 шагов уже мало что меняется, я, со своей стороны, ставлю от 50 до 100, в случае с масками кажется, что итоговый рисунок чище, возможно самовнушение.

img2img - с тем же самым текстовым описанием можно добавить фото и настроить так, чтобы полученное изображение было хоть как-то на него похоже

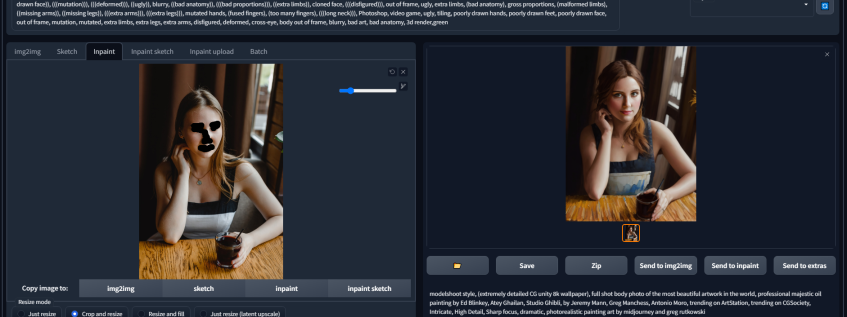

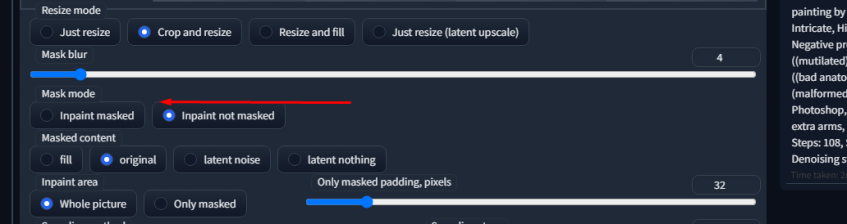

А Маска это вкладка Inpaint. Тут на изображении можно указать зоны, которые ты хочешь чтобы обработчик не интерпретировал или наоборот, интерпретировал только их (в моем мозгу все понимают, что я имею в виду "либо преображал, либо игнорировал").

Есть так же вкладка Scetch - разными цветами схематично нарисовать/обозначить рисунок и кинуть это в жерло генератора.

От набора выборки, как вы подкрутите бегунки зависит многое, но можно в выбранном варианте, который вам понравился, создать несколько картинок и даже будут хорошие отличия, будет из чего выбрать.

Я как скачивал модели для генерации, так и просто в поиске искал популярные промты. До чего-то более взрослого я не дошел, но решил создать что-то, что не является ни инструкцией по установке, ни руководством пользователя, ни вообще чем-то полезным, развязка раскрывается в начале текста, как принято у Донцовой, Кинга и [вписать имя популярного писателя, с банальным развитием сюжета ]

Лучшие комментарии

О, есть куда прилепить моих шреков)) Угадайте кто есть кто

Адский анимешный Кулаков)

Игривый Лёня

Мультивселенных по Стопгейму кажется и так уже много. Но это не помешает появиться ещё одной.

Лёня, Лёня, Лёня.

Какой ты Лёня сегодня)

Неплохо получилось.

Ну, как-то без упоминания ControlNet не то. Всё-таки он даёт, как ни странно, гораздо больше контроля над img2img, поэтому его так все сейчас хайпят. А так неплохой материал для новичков, которые впервые слышат о подобных нейронках. Может портреты авторов портала и вдохновят кого-то на создание собственных шедевров.

Угадай какой настоящий

спасибо за отзыв и информацию, про ControlNet даже не знал, буду смотреть в этом направлении)